Wat is opleidingsdata in masjienleer:

Definisie, Voordele, Uitdagings, Voorbeeld & Datastelle

Die uiteindelike kopersgids 2023

Inleiding

In die wêreld van kunsmatige intelligensie en masjienleer is data -opleiding onvermydelik. Dit is die proses wat masjienleermodules akkuraat, doeltreffend en ten volle funksioneel maak. In hierdie pos ondersoek ons in detail wat AI -opleidingsdata is, kwaliteit van die opleiding, data -insameling en lisensiëring en meer.

Na raming neem 'n volwassene gemiddeld besluite oor die lewe en alledaagse dinge op grond van vorige leer. Dit kom op hul beurt uit lewenservarings gevorm deur situasies en mense. In letterlike sin is situasies, gevalle en mense niks anders as data wat in ons gedagtes gevoer word nie. Terwyl ons jare se data in die vorm van ervaring ophoop, is die mens se verstand geneig om naatlose besluite te neem.

Wat dra dit oor? Daardie gegewens is onvermydelik om te leer.

Net soos 'n kind 'n etiket benodig wat 'n alfabet genoem word om die letters A, B, C, D te verstaan, moet 'n masjien ook die data wat hy ontvang, verstaan.

Dit is presies wat Kunsmatige Intelligensie (AI) opleiding gaan alles oor. 'N Masjien is nie anders as 'n kind wat nog dinge moet leer uit wat dit gaan leer nie. Die masjien weet nie om 'n onderskeid te tref tussen 'n kat en 'n hond of 'n bus en 'n motor nie, want hulle het nog nie die items ervaar of geleer hoe dit lyk nie.

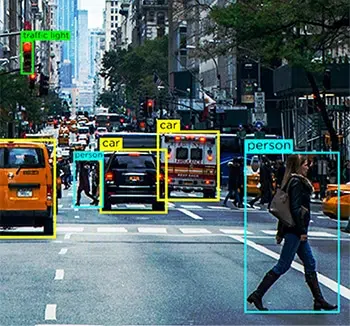

Dus, vir iemand wat 'n selfbestuurde motor bou, is die primêre funksie wat bygevoeg moet word, die vermoë van die stelsel om al die alledaagse elemente wat die motor kan ervaar te verstaan, sodat die voertuig dit kan identifiseer en toepaslike bestuursbesluite kan neem. Dit is waar KI-opleidingsdata kom in die spel.

Vandag bied kunsmatige intelligensie -modules ons baie geriewe in die vorm van aanbeveling -enjins, navigasie, outomatisering en meer. Dit alles gebeur as gevolg van AI -data -opleiding wat gebruik is om die algoritmes op te lei terwyl dit gebou is.

KI-opleidingsdata is 'n fundamentele proses om te bou machine learning en KI-algoritmes. As u 'n app ontwikkel wat gebaseer is op hierdie tegnologiese konsepte, moet u u stelsels oplei om data-elemente te verstaan vir optimale verwerking. Sonder opleiding sal u KI-model ondoeltreffend, gebrekkig en potensieel nutteloos wees.

Na raming spandeer datawetenskaplikes meer as 80% van hul tyd in data -voorbereiding en verryking om ML -modelle op te lei.

Dus, vir diegene onder u wat finansiering wil kry van waagkapitaliste, die solopreneurs daar buite wat aan ambisieuse projekte werk en tegnologie-entoesiaste wat pas met gevorderde AI begin, het ons hierdie gids ontwikkel om die belangrikste vrae te beantwoord u KI-opleidingsdata.

Hier sal ons ondersoek wat AI -opleidingsdata is, waarom is dit onvermydelik in u proses, die volume en kwaliteit van die data wat u eintlik benodig, en meer.

Wat is AI-opleidingsdata?

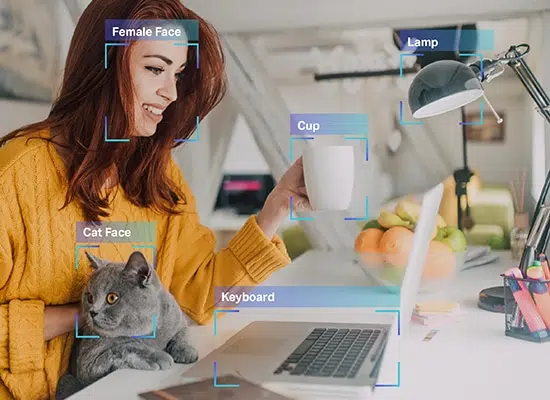

KI-opleidingsdata is noukeurig saamgestel en skoongemaakte inligting wat vir opleidingsdoeleindes in 'n stelsel ingevoer word. Hierdie proses maak of breek 'n KI-model se sukses. Dit kan help om die begrip te ontwikkel dat nie alle viervoetige diere in 'n beeld honde is nie, of dit kan 'n model help om te onderskei tussen kwaai geskree en vreugdevolle lag. Dit is die eerste fase in die bou van kunsmatige intelligensie-modules wat lepelvoerdata vereis om masjiene die basiese beginsels te leer en hulle in staat te stel om te leer namate meer data gevoer word. Dit maak weer plek vir 'n doeltreffende module wat presiese resultate aan eindgebruikers uitdeel.

Beskou 'n KI-opleidingsdataproses as 'n oefensessie vir 'n musikant, waar hoe meer hulle oefen, hoe beter word hulle op 'n liedjie of 'n skaal. Die enigste verskil hier is dat masjiene ook eers geleer moet word wat 'n musiekinstrument is. Soortgelyk aan die musikant wat goed gebruik maak van die ontelbare ure wat op die verhoog spandeer word, bied 'n KI-model 'n optimale ervaring aan verbruikers wanneer dit ontplooi word.

Waarom is AI-opleidingsdata nodig?

Die eenvoudigste antwoord waarom AI-opleidingsdata nodig is vir die ontwikkeling van 'n model, is dat masjiene daarsonder nie eers sou weet wat om te begryp nie. Soos 'n individu wat opgelei is vir sy spesifieke werk, het 'n masjien 'n hoeveelheid inligting nodig om ook 'n spesifieke doel te bereik en om ooreenstemmende resultate te lewer.

Kom ons kyk weer na die voorbeeld van outonome motors. Terabyte na terabyte data in 'n selfbesturende voertuig kom van verskeie sensors, rekenaarvisie-toestelle, RADAR, LIDAR's en nog baie meer. Al hierdie groot stukke data sou sinneloos wees as die sentrale verwerkingstelsel van die motor nie weet wat om daarmee te doen nie.

Byvoorbeeld, die rekenaarvisie die eenheid van die motor kan hoeveelhede data oor padelemente soos voetgangers, diere, slaggate en meer spoeg. As die masjienleermodule nie opgelei is om dit te identifiseer nie, sou die voertuig nie weet dat dit hindernisse is wat ongelukke kan veroorsaak as dit voorkom nie. Daarom moet die modules opgelei word in wat elke element in die pad is en hoe verskillende bestuursbesluite vir elkeen nodig is.

Alhoewel dit net vir visuele elemente is, moet die motor ook die menslike instruksies kan verstaan Natuurlike Taalverwerking (NLP) en klank- of spraakversameling en reageer daarvolgens. As die bestuurder byvoorbeeld die infotainment-stelsel in die motor beveel om na vulstasies in die omgewing te soek, moet hy die vereiste kan verstaan en gepaste resultate kan oplewer. Daarvoor moet dit egter in staat wees om elke woord in die frase te verstaan, dit te verbind en die vraag te kan verstaan.

Alhoewel u kan wonder of die proses van AI-opleidingsdata slegs ingewikkeld is omdat dit gebruik word vir 'n swaar gebruiksgeval soos 'n outonome motor, is die feit dat die volgende film wat Netflix aanbeveel, dieselfde proses gaan doen om u persoonlike voorstelle te bied. Enige app, platform of 'n entiteit wat AI verbind, word standaard aangedryf deur AI-opleidingsdata.

Watter tipe data het ek nodig?

Daar is 4 primêre tipes data wat benodig word, naamlik beeld, video, klank/spraak of teks om masjienleermodelle effektief op te lei. Die tipe data wat benodig word, sal afhang van 'n verskeidenheid faktore, soos die gebruiksgebruik in die hand, die kompleksiteit van modelle wat opgelei moet word, die opleidingsmetode en die diversiteit van die benodigde insetdata.

Hoeveel data is voldoende?

Hulle sê daar is geen einde aan leer nie en hierdie frase is ideaal in die KI-opleidingsspektrum. Hoe meer die data is, hoe beter is die resultate. 'N Antwoord so vaag soos dit is egter nie genoeg om iemand te oortuig wat op soek is na 'n AI-aangedrewe app nie. Maar die werklikheid is dat daar geen algemene reël is nie, 'n formule, 'n indeks of 'n meting van die presiese volume data wat nodig is om hul AI-datastelle op te lei.

'N Masjienleerkundige sal komies onthul dat 'n aparte algoritme of module gebou moet word om die hoeveelheid data wat nodig is vir 'n projek af te lei. Dit is ongelukkig ook die werklikheid.

Daar is nou 'n rede waarom dit baie moeilik is om die hoeveelheid data wat nodig is vir KI-opleiding te beperk. Dit is as gevolg van die ingewikkeldheid in die opleidingsproses self. 'N KI-module bestaan uit verskillende lae onderling gekoppelde en oorvleuelende fragmente wat mekaar se prosesse beïnvloed en aanvul.

Laat ons byvoorbeeld dink dat u 'n eenvoudige app ontwikkel om 'n klapperboom te herken. Volgens die vooruitsig klink dit nogal eenvoudig, of hoe? Vanuit 'n KI-perspektief is dit egter baie meer kompleks.

Aan die begin is die masjien leeg. Dit weet in die eerste plek nie wat 'n boom is nie, wat nog te sê van 'n hoë, streekspesifieke, tropiese vrugdraende boom. Daarvoor moet die model opgelei word in wat 'n boom is, hoe om te onderskei van ander lang en skraal voorwerpe wat in die raam kan verskyn, soos straatligte of elektriese pale, en dan verder gaan om die nuanses van 'n klapperboom te leer. As die masjienleermodule eers geleer het wat 'n klapperboom is, kan 'n mens seker aanvaar dat hy dit kan herken.

Maar slegs as u 'n beeld van 'n banyanboom voed, sou u besef dat die stelsel 'n banyanboom vir 'n klapperboom verkeerd geïdentifiseer het. Vir 'n stelsel is alles wat hoog is met gegroepeerde blare 'n klapperboom. Om dit uit die weg te ruim, moet die stelsel nou elke boom wat nie 'n klapperboom is nie, presies verstaan. As dit die proses is vir 'n eenvoudige eenrigting -app met net een uitkoms, kan ons ons net die kompleksiteite voorstel wat betrokke is by programme wat ontwikkel is vir gesondheidsorg, finansies en meer.

Afgesien hiervan, wat beïnvloed ook die hoeveelheid data waarvoor benodig word opleiding sluit die volgende aspekte in:

- Opleidingsmetode, waar die verskille in datatipes (gestruktureerd en ongestruktureerd) beïnvloed die behoefte aan hoeveelhede data

- Data -etikettering of aantekeningstegnieke

- Die manier waarop data na 'n stelsel gevoer word

- Fouttoleransie kwosiënt, wat eenvoudig die persentasie van foute wat weglaatbaar is in u nis of domein

Reële voorbeelde van opleidingsvolumes

Die hoeveelheid data wat u benodig om u modules op te lei, hang af oor u projek en die ander faktore wat ons vroeër bespreek het, 'n bietjie inspirasie of verwysing kan help om 'n uitgebreide idee van data te kry vereistes.

Die volgende is werklike voorbeelde van die hoeveelheid datastelle wat gebruik word vir KI-opleidingsdoeleindes deur uiteenlopende ondernemings en besighede.

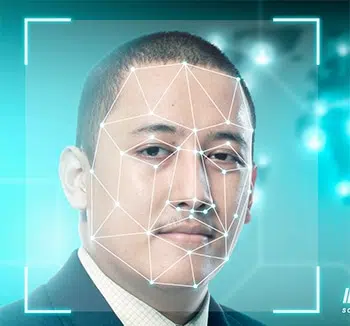

- Gesigherkenning - 'n steekproefgrootte van meer as 450,000 XNUMX gesigsbeelde

- Prentantekening - 'n steekproefgrootte van meer as 185,000 XNUMX beelde met byna 650,000 XNUMX geannoteerde voorwerpe

- Facebook-sentimentontleding - 'n steekproefgrootte van meer as 9,000 opmerkings en 62,000 XNUMX plasings

- Chatbot-opleiding - 'n steekproefgrootte van meer as 200,000 XNUMX vrae met meer as 2 miljoen antwoorde

- Vertaal-app - 'n steekproefgrootte van meer as 300,000 klank of spraak versameling van nie-moedertaalsprekers

Wat as ek nie genoeg data het nie?

In die wêreld van AI & ML is data -opleiding onvermydelik. Daar word tereg gesê dat daar geen einde is aan die leer van nuwe dinge nie, en dit geld ook as ons praat oor die AI -opleidingsdataspektrum. Hoe meer data, hoe beter die resultate. Daar is egter gevalle waar die gebruiksgeval wat u probeer oplos, betrekking het op 'n niskategorie, en die verkryging van die regte dataset op sigself 'n uitdaging is. Dus, in hierdie scenario, as u nie oor voldoende data beskik nie, is die voorspellings van die ML -model moontlik nie akkuraat of bevooroordeeld. Daar is maniere soos datavergroting en data -opmaak wat u kan help om die tekortkominge te oorkom, maar die resultaat is moontlik steeds nie akkuraat of betroubaar nie.

Hoe verbeter u die datakwaliteit?

Die kwaliteit van data is direk eweredig aan die kwaliteit van die uitset. Daarom benodig baie akkurate modelle datastelle van hoë gehalte vir opleiding. Daar is egter 'n vangplek. Vir 'n konsep wat afhanklik is van presisie en akkuraatheid, is die konsep van kwaliteit dikwels vaag.

Data van hoë gehalte klink sterk en geloofwaardig, maar wat beteken dit eintlik?

Wat is kwaliteit in die eerste plek?

Net soos die gegewens wat ons in ons stelsels invoer, hou kwaliteit ook baie faktore en parameters in. As u kontak maak met AI-kundiges of veterane vir masjienleer, sal hulle moontlik enige permutasie van hoë gehalte data deel -

- Uniform - data wat afkomstig is van een spesifieke bron of eenvormigheid in datastelle wat van verskeie bronne afkomstig is

- Omvattende - data wat alle moontlike scenario's dek waaraan u stelsel wil werk

- konsekwent - elke enkele greep data is soortgelyk

- relevante - die data wat u verkry en voer ooreenstem met u vereistes en verwagte uitkomste en

- Verskeie - u het 'n kombinasie van alle soorte data soos klank, video, beeld, teks en meer

Noudat ons verstaan wat kwaliteit van datakwaliteit beteken, moet ons vinnig kyk na die verskillende maniere waarop ons kwaliteit kan verseker data-insameling en generasie.

1. Kyk uit vir gestruktureerde en ongestruktureerde data. Eersgenoemde is maklik verstaanbaar deur masjiene omdat dit elemente en metadata bevat. Laasgenoemde is egter nog rou, sonder waardevolle inligting waarvan 'n stelsel kan gebruik. Dit is waar data -aantekeninge inkom.

2. Die uitskakeling van vooroordeel is 'n ander manier om kwaliteit data te verseker, aangesien die stelsel enige vooroordeel uit die stelsel verwyder en 'n objektiewe resultaat lewer. Vooroordeel skeef net u resultate en maak dit nutteloos.

3. Maak data deeglik skoon, aangesien dit altyd die kwaliteit van u uitsette sal verhoog. Enige data -wetenskaplike sal u vertel dat 'n groot deel van hul taak rol is om data skoon te maak. As u u data skoonmaak, verwyder u duplikaat, geraas, ontbrekende waardes, strukturele foute, ens.

Wat beïnvloed die kwaliteit van opleidingsdata?

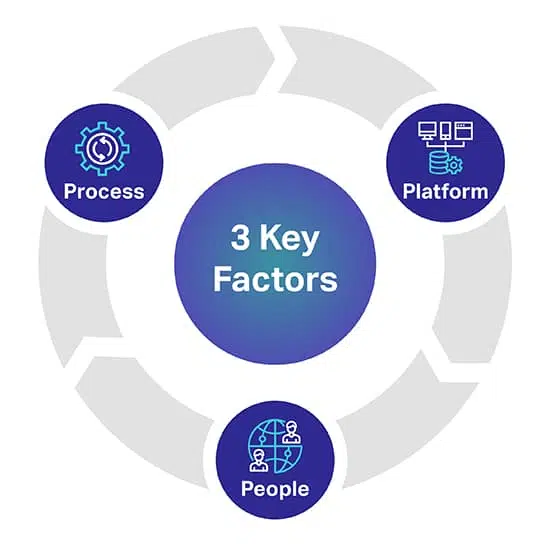

Daar is drie hooffaktore wat u kan help om die kwaliteit van u AI/ML -modelle te voorspel. Die drie sleutelfaktore is mense, proses en platform wat u AI -projek kan maak of breek.

Platform: 'N Volledige menslike-in-die-loop-eie platform is nodig om verskillende datastelle te kry, te transkribeer en aan te teken om die mees veeleisende AI- en ML-inisiatiewe suksesvol te implementeer. Die platform is ook verantwoordelik om werknemers te bestuur en om die kwaliteit en deurset te maksimeer

mense: Om AI slimmer te laat dink, is mense wat een van die slimste verstand in die bedryf is. Om op te skaal, benodig u duisende van hierdie professionele persone regoor die wêreld om alle datatipes te transkribeer, etiketteer en annoteer.

Proses: Die verskaffing van goudstandaarddata wat konsekwent, volledig en akkuraat is, is ingewikkelde werk. Maar dit is wat u altyd moet lewer, om aan die hoogste kwaliteitstandaarde te voldoen, sowel as streng en beproefde kwaliteitskontroles en kontrolepunte.

Waar kry u AI-opleidingsdata vandaan?

Anders as ons vorige afdeling, het ons hier 'n baie presiese insig. Vir diegene onder u wat data wil soek

of as u besig is met videoversameling, beeldversameling, teksversameling en meer, is daar drie

primêre paaie waaruit u u data kan verkry.

Kom ons ondersoek dit individueel.

Gratis bronne

Gratis bronne is paaie wat onwillekeurige bewaarplekke is vir groot hoeveelhede data. Dit is gegewens wat eenvoudig gratis daar op die oppervlak lê. Sommige van die gratis hulpbronne sluit in:

- Google-datastelle, waar meer as 250 miljoen stelle data in 2020 vrygestel is

- Forums soos Reddit, Quora en meer, wat vindingryke bronne vir data is. Boonop kan datawetenskap en AI-gemeenskappe in hierdie forums u ook help met spesifieke datastelle wanneer u dit bereik.

- Kaggle is nog 'n gratis bron waar u masjienleerbronne kan vind, afgesien van gratis datastelle.

- Ons het ook gratis oop datastelle gelys om u te begin met die opleiding van u AI-modelle

Alhoewel hierdie maniere gratis is, is u tyd en moeite om te spandeer. Data van gratis bronne is oral beskikbaar en u moet ure se werk bestee aan die verkryging, skoonmaak en aanpassing volgens u behoeftes.

Een van die ander belangrike wenke om te onthou, is dat sommige van die data uit gratis bronne ook nie vir kommersiële doeleindes gebruik kan word nie. Dit vereis data lisensiëring.

Skrap van data

Soos die naam aandui, is die skraap van data die proses om data uit verskeie bronne te ontgin met gepaste gereedskap. Van webwerwe, openbare portale, profiele, tydskrifte, dokumente en meer, kan instrumente die nodige data skraap en dit naatloos na u databasis bring.

Alhoewel dit na 'n ideale oplossing klink, is data -skraap slegs wettig as dit by persoonlike gebruik kom. As u 'n onderneming is wat data wil skraap met kommersiële ambisies, word dit lastig en selfs onwettig. Daarom het u 'n regspan nodig om na webwerwe, nakoming en voorwaardes te kyk voordat u die data wat u benodig, kan skraap.

Eksterne verskaffers

Wat die insameling van data vir KI-opleidingsdata betref, is uitkontraktering of uitreik na eksterne verskaffers vir datastelle die ideaalste opsie. Hulle neem die verantwoordelikheid om datastelle vir u behoeftes te vind terwyl u kan fokus op die bou van u modules. Dit is spesifiek om die volgende redes:

- u hoef nie ure te spandeer om data te soek nie

- daar is geen pogings ten opsigte van die skoonmaak en klassifikasie van data betrokke nie

- u kry kwaliteit datastelle in die hand wat al die faktore wat ons bespreek het, 'n geruime tyd nagaan

- u kan datastelle kry wat pas by u behoeftes

- u kan die hoeveelheid data benodig wat u benodig vir u projek en meer

- en die belangrikste, hulle sorg ook dat hul data-insameling en die data self aan die plaaslike regulatoriese riglyne voldoen.

Die enigste faktor wat afhangend van u omvang van die bedrywighede 'n tekortkoming kan wees, is dat uitgawes uitgawes behels. Weereens, wat nie uitgawes behels nie.

Shaip is reeds 'n leier op die gebied van data-insamelingsdienste en het 'n eie bewaarplek van gesondheidsdata en spraak- / klank-datastelle wat gelisensieer kan word vir u ambisieuse KI-projekte.

Oop datastelle - Gebruik of nie gebruik nie?

Daar is byvoorbeeld die Amazon-produkbeoordelingsdatastel wat meer as 142 miljoen gebruikersresensies bevat van 1996 tot 2014. Vir beelde het u 'n uitstekende bron soos Google Open Images, waar u datastelle uit meer as 9 miljoen foto's kan kry. Google het ook 'n vleuel genaamd Machine Perception wat byna 2 miljoen klankgrepe van tien sekondes aanbied.

Ondanks die beskikbaarheid van hierdie hulpbronne (en ander), is die belangrikste faktor wat dikwels oor die hoof gesien word, die toestande wat daarmee gepaard gaan. Hulle is beslis publiek, maar daar is 'n dun lyn tussen oortreding en billike gebruik. Elke hulpbron het sy eie toestand en as u hierdie opsies ondersoek, raai ons u aan om versigtig te wees. Dit is omdat u onder die voorwendsel van die verkiesing van gratis paaie regsgedinge en verwante uitgawes kan aangaan.

Die ware koste van AI-opleidingsdata

Slegs die geld wat jy spandeer om die data te bekom of data in die huis te genereer, is nie wat jy moet oorweeg nie. Ons moet lineêre elemente oorweeg soos tyd en pogings wat spandeer word om KI-stelsels te ontwikkel en kos vanuit 'n transaksionele perspektief. versuim om die ander te komplimenteer.

Tyd bestee aan die verkryging en aantekening van data

Faktore soos aardrykskunde, markdemografie en mededinging binne u nis belemmer die beskikbaarheid van relevante datastelle. Die tyd wat u met die hand soek na data, spandeer tyd in die opleiding van u AI-stelsel. Sodra u daarin geslaag het om u data te verkry, sal u die opleiding verder vertraag deur tyd te spandeer om die data aan te meld, sodat u masjien kan verstaan wat dit gevoer word.

Die prys van die insameling en aantekening van data

Oorhoofse uitgawes (interne data-insamelaars, aantekenaars, instandhoudingstoerusting, tegniese infrastruktuur, intekeninge op SaaS-gereedskap, ontwikkeling van eie toepassings) moet bereken word tydens die verkryging van AI-data

Die koste van slegte data

Slegte data kan u onderneming se span moraal kos, u mededingingsvoorsprong en ander tasbare gevolge wat ongemerk bly. Ons definieer slegte data as enige datastel wat onrein, rou, irrelevant, verouderd, onakkuraat of vol spelfoute is. Slegte data kan u AI -model bederf deur vooroordeel in te stel en u algoritmes te beskadig met skewe resultate.

Bestuurskoste

Alle koste verbonde aan die administrasie van u organisasie of onderneming, tasbare en ontasbare besittings is die bestuurskoste wat dikwels die duurste is.

Wat volgende na Data Sourcing?

Sodra u die datastel in u hand het, is die volgende stap om dit aan te teken of te benoem. Na al die ingewikkelde take is dit skoon rou data. Die masjien kan steeds nie die data wat u het verstaan nie, omdat dit nie geannoteer is nie. Dit is waar die oorblywende gedeelte van die werklike uitdaging begin.

Soos ons genoem het, benodig 'n masjien data in 'n formaat wat dit kan verstaan. Dit is presies wat data-aantekening doen. Dit verg rou data en voeg lae etikette en etikette by om 'n module te help om elke element in die data akkuraat te verstaan.

In 'n teks sal data-etikettering byvoorbeeld aan 'n KI-stelsel die grammatikale sintaksis, woordsoort, voorsetsels, leestekens, emosie, sentiment en ander parameters wat betrokke is by masjienbegrip, vertel. Dit is hoe chatbots menslike gesprekke beter verstaan en slegs as hulle dit doen, kan hulle ook interaksie tussen mense beter naboots.

Hoe onvermydelik dit ook al klink, dit is ook uiters tydrowend en vervelig. Ongeag die omvang van u onderneming of die ambisies, die tyd wat dit neem om data aan te meld, is groot.

Dit is hoofsaaklik omdat u bestaande arbeidsmag tyd uit hul daaglikse skedule moet spandeer om data aan te meld as u nie spesialiste in data -aantekeninge het nie. U moet dus u spanlede ontbied en dit as 'n bykomende taak toewys. Hoe meer dit vertraag word, hoe langer neem dit om u AI -modelle op te lei.

Alhoewel daar gratis hulpmiddels is vir die aantekening van data, neem dit nie die feit dat hierdie proses tydrowend is weg nie.

Dit is hier waar dataverskaffers soos Shaip inkom. Hulle bring 'n toegewyde span data-aantekeningspesialiste saam om net op u projek te fokus. Hulle bied u oplossings op die manier wat u wil hê vir u behoeftes en vereistes. Boonop kan u 'n tydsraamwerk daarvoor opstel en eis dat die werk in die spesifieke tydlyn voltooi moet word.

Een van die belangrikste voordele is die feit dat u interne spanlede kan voortgaan om te fokus op wat meer belangrik is vir u werksaamhede en projekte, terwyl kundiges hul werk doen om data vir u aan te teken en te etiketteer.

Met uitkontraktering kan optimale kwaliteit, minimale tyd en maksimum presisie verseker word.

Wikkel

Dit was alles oor AI -opleidingsdata. Van die verstaan van opleidingsdata tot die ondersoek van gratis hulpbronne en die voordele van uitkontraktering van data -aantekeninge, het ons almal bespreek. Weereens is protokolle en beleide nog steeds wankelrig in hierdie spektrum, en ons beveel u altyd aan om in kontak te kom met AI -opleidingsdata -kundiges soos ons vir u behoeftes.

Van verkryging, de-identifisering tot data-annotasie, ons sal u help met al u behoeftes, sodat u slegs kan werk aan die bou van u platform. Ons verstaan die ingewikkeldhede van die verkryging en etikettering van data. Daarom herhaal ons die feit dat u die moeilike take aan ons kan oorlaat en van ons oplossings gebruik kan maak.

Kontak ons vandag vir al u data -aantekeningbehoeftes.

Kom ons praat

Algemene vrae (FAQ)

As u intelligente stelsels wil skep, moet u skoongemaakte, saamgestelde en uitvoerbare inligting invoer om leer onder toesig te vergemaklik. Die benoemde inligting word AI -opleidingsdata genoem en bestaan uit markmetadata, ML -algoritmes en alles wat help met besluitneming.

Elke AI-aangedrewe masjien het funksies wat beperk is tot sy historiese posisie. Dit beteken dat die masjien slegs die gewenste uitkoms kan voorspel as dit voorheen met vergelykbare datastelle opgelei is. Opleidingsdata help met opleiding onder toesig met die volume wat direk eweredig is aan die doeltreffendheid en akkuraatheid van die AI -modelle.

Daar is verskillende opleidingsdatastelle nodig om spesifieke masjienleer-algoritmes op te lei, om die AI-aangedrewe opstellings te help om belangrike besluite te neem met die kontekste in gedagte. As u byvoorbeeld van plan is om Computer Vision -funksies by 'n masjien te voeg, moet die modelle opgelei word met geannoteerde beelde en meer markdatastelle. Net so, vir NLP -vaardigheid, dien groot hoeveelhede spraakversameling as opleidingsdata.

Daar is geen boonste limiet vir die hoeveelheid opleidingsdata wat benodig word om 'n bekwame AI -model op te lei nie. Hoe groter die datavolume, sal die model se vermoë wees om elemente, tekste en kontekste te identifiseer en te skei.

Alhoewel daar baie data beskikbaar is, is nie elke deel geskik vir die opleiding van modelle nie. Om 'n algoritme op sy beste te laat werk, benodig u omvattende, konsekwente en relevante datastelle, wat eenvormig onttrek is, maar steeds uiteenlopend genoeg is om 'n wye verskeidenheid scenario's te dek. Ongeag die data wat u van plan is om te gebruik, is dit beter om dieselfde skoon te maak en dit aan te meld vir verbeterde leer.

As u 'n spesifieke AI-model in gedagte het, maar die opleidingsdata nie heeltemal genoeg is nie, moet u eers uitskieters verwyder, oordrag- en iteratiewe leeropsette koppel, funksies beperk en die opstelling open-source maak sodat gebruikers aanhou om data by te voeg vir geleidelik, betyds, die masjien op te lei. U kan selfs benaderings rakende data -uitbreiding en oordragleer volg om die meeste uit beperkte datastelle optimaal te benut.

Oop datastelle kan altyd gebruik word om opleidingsdata te versamel. As u egter eksklusiwiteit soek om die modelle beter op te lei, kan u staatmaak op eksterne verskaffers, gratis bronne soos Reddit, Kaggle en meer, en selfs Data Scraping om selektief insigte uit profiele, portale en dokumente te ontgin. Ongeag die benadering, is dit nodig om die verkrygde data te formateer, te verminder en skoon te maak voordat dit gebruik word.