Groot Taalmodelle (LLM): Volledige Gids in 2023

Alles wat jy moet weet oor LLM

Laai e-boek af

Inleiding

Het jy al ooit jou kop gekrap, verbaas oor hoe Google of Alexa jou 'gekry' het? Of het jy al gevind dat jy 'n rekenaar-gegenereerde opstel lees wat vreeslik menslik klink? Jy is nie alleen nie. Dit is tyd om die gordyn terug te trek en die geheim te openbaar: Groot Taalmodelle, of LLM's.

Wat is dit, vra jy? Dink aan LLM's as versteekte towenaars. Hulle dryf ons digitale geselsies aan, verstaan ons verwarde frases en skryf selfs soos ons. Hulle verander ons lewens, maak wetenskapfiksie 'n werklikheid.

Hierdie gids handel oor alles oor LLM. Ons sal ondersoek wat hulle kan doen, wat hulle nie kan doen nie, en waar hulle gebruik word. Ons sal in eenvoudige en eenvoudige taal ondersoek hoe hulle ons almal beïnvloed.

Dus, kom ons begin ons opwindende reis na LLM's.

Vir wie is hierdie gids?

Hierdie uitgebreide gids is vir:

- Al u entrepreneurs en solopreneurs wat gereeld baie data versamel

- KI en masjienleer of professionele persone wat met prosesoptimaliseringstegnieke begin

- Projekbestuurders wat van plan is om 'n vinniger tydsbestek vir hul AI-modules of AI-gedrewe produkte te implementeer

- En tegnologie-entoesiaste wat graag inligting wil gee oor die lae wat by KI-prosesse betrokke is.

Wat is groot taalmodelle?

Groot taalmodelle (LLM's) is gevorderde kunsmatige intelligensie (KI) stelsels wat ontwerp is om mensagtige teks te verwerk, te verstaan en te genereer. Hulle is gebaseer op diep leertegnieke en opgelei op massiewe datastelle, wat gewoonlik miljarde woorde bevat uit uiteenlopende bronne soos webwerwe, boeke en artikels. Hierdie uitgebreide opleiding stel LLM's in staat om die nuanses van taal, grammatika, konteks en selfs sommige aspekte van algemene kennis te begryp.

Sommige gewilde LLM's, soos OpenAI se GPT-3, gebruik 'n tipe neurale netwerk wat 'n transformator genoem word, wat hulle in staat stel om komplekse taaltake met merkwaardige vaardigheid te hanteer. Hierdie modelle kan 'n wye reeks take verrig, soos:

- Beantwoord vrae

- Opsommende teks

- Vertaling van tale

- Genereer inhoud

- Selfs interaktiewe gesprekke met gebruikers betrokke

Soos LLM's voortgaan om te ontwikkel, hou hulle groot potensiaal in om verskeie toepassings oor industrieë heen te verbeter en te outomatiseer, van kliëntediens en inhoudskepping tot onderwys en navorsing. Hulle opper egter ook etiese en maatskaplike bekommernisse, soos bevooroordeelde gedrag of misbruik, wat aangespreek moet word namate tegnologie vorder.

Noodsaaklike faktore in die konstruksie van 'n LLM-datakorpus

Jy moet 'n omvattende datakorpus bou om taalmodelle suksesvol op te lei. Hierdie proses behels die insameling van groot data en die versekering van die hoë gehalte en relevansie daarvan. Kom ons kyk na die sleutelaspekte wat die ontwikkeling van 'n effektiewe databiblioteek vir taalmodel-opleiding aansienlik beïnvloed.

Prioritiseer datakwaliteit langs kwantiteit

'n Groot datastel is fundamenteel vir die opleiding van taalmodelle. Tog is daar baie betekenis verbonde aan datakwaliteit. Modelle wat op uitgebreide maar swak gestruktureerde data opgelei is, kan onakkurate uitkomste lewer.

Omgekeerd lei kleiner, noukeurig saamgestelde datastelle dikwels tot voortreflike werkverrigting. Hierdie werklikheid toon die belangrikheid van 'n gebalanseerde benadering tot data-insameling. Data verteenwoordigend, divers en pertinent tot die model se beoogde omvang vereis ywerige keuse, skoonmaak en organisering.

Kies Gepaste databronne

Die keuse van databronne moet ooreenstem met die model se spesifieke toepassingsdoelwitte.

- Modelle wat dialoog genereer sal baat by bronne soos gesprekke en onderhoude is van onskatbare waarde.

- Modelle wat op kodegenerering fokus, sal baat vind by goed gedokumenteerde kodebewaarplekke.

- Literêre werke en draaiboeke bied 'n magdom opleidingsmateriaal vir diegene wat kreatiewe skryfwerk teiken.

Jy moet data insluit wat oor die beoogde tale en onderwerpe strek. Dit help jou om die model aan te pas om effektief te presteer binne sy aangewese domein.

Gebruik sintetiese datagenerering

Die verbetering van jou datastel met sintetiese data kan leemtes vul en sy omvang uitbrei. Jy kan datavergroting, teksgenereringsmodelle en reëlgebaseerde generering gebruik om kunsmatige data te skep wat werklike patrone weerspieël. Hierdie strategie verbreed die diversiteit van die opleidingstel om die model se veerkragtigheid te verbeter en vooroordele te help verminder.

Maak seker dat jy die sintetiese data se kwaliteit verifieer sodat dit positief bydra tot die model se vermoë om taal binne sy teikendomein te verstaan en te genereer.

Implementeer outomatiese data-insameling

Outomatisering vir die data-insamelingsproses fasiliteer die konsekwente integrasie van vars, relevante data. Hierdie benadering stroomlyn data-verkryging, verhoog skaalbaarheid en bevorder reproduceerbaarheid.

U kan verskillende datastelle doeltreffend insamel deur webskraapnutsmiddels, API's en data-innameraamwerke te gebruik. U kan hierdie nutsgoed verfyn om op relevante data van hoë gehalte te fokus. Hulle optimaliseer die opleidingsmateriaal vir die model. U moet hierdie geoutomatiseerde stelsels voortdurend monitor om hul akkuraatheid en etiese integriteit te handhaaf.

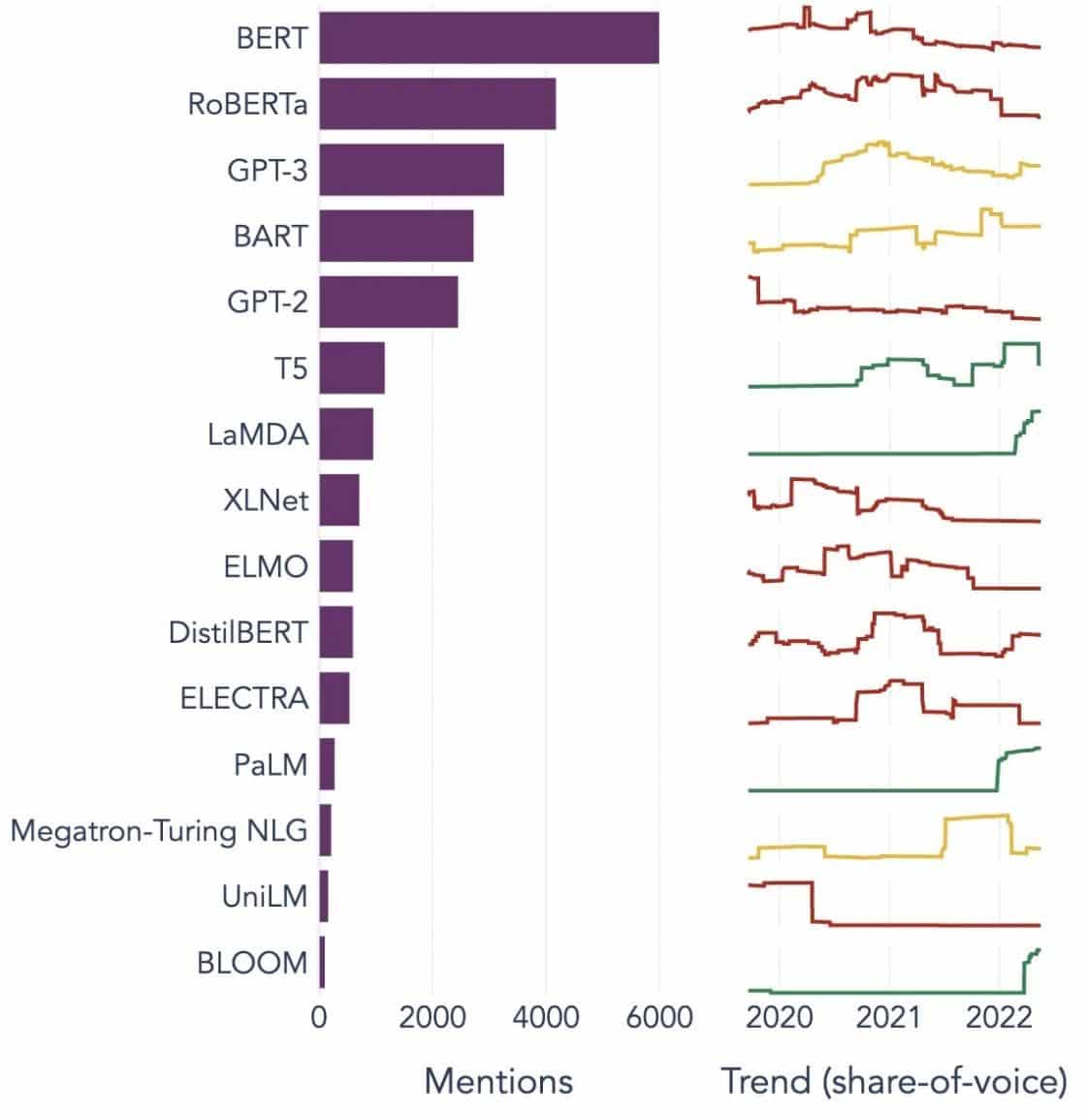

Gewilde voorbeelde van groot taalmodelle

Hier is 'n paar prominente voorbeelde van LLM's wat wyd in verskillende industrie-vertikale gebruik word:

Image Bron: Op pad na datawetenskap

Verstaan die boustene van groot taalmodelle (LLM's)

Om die vermoëns en werking van LLM's ten volle te begryp, is dit belangrik om ons met 'n paar sleutelkonsepte te vergewis. Dit sluit in:

Woordbediening

Dit verwys na die praktyk om woorde in 'n numeriese formaat te vertaal wat KI-modelle kan interpreteer. In wese is woordinbedding die KI se taal. Elke woord word voorgestel as 'n hoë-dimensionele vektor wat sy semantiese betekenis inkapsuleer gebaseer op sy konteks in die opleidingsdata. Hierdie vektore laat die KI toe om verwantskappe en ooreenkomste tussen woorde te verstaan, wat die model se begrip en werkverrigting verbeter.

Aandagmeganismes

Hierdie gesofistikeerde komponente help die KI-model om sekere elemente binne die invoerteks bo ander te prioritiseer wanneer 'n uitset gegenereer word. Byvoorbeeld, in 'n sin gevul met verskeie sentimente, kan 'n aandagmeganisme groter gewig aan die sentimentdraende woorde gee. Hierdie strategie stel die KI in staat om meer kontekstueel akkurate en genuanseerde antwoorde te genereer.

Transformers

Transformators verteenwoordig 'n gevorderde tipe neurale netwerkargitektuur wat wyd gebruik word in LLM-navorsing. Wat transformators onderskei, is hul selfaandagmeganisme. Hierdie meganisme laat die model toe om alle dele van die insetdata gelyktydig te weeg en te oorweeg, eerder as in opeenvolgende volgorde. Die resultaat is 'n verbetering in die hantering van langafstandafhanklikhede in die teks, 'n algemene uitdaging in natuurlike taalverwerkingstake.

Fyn instelling

Selfs die mees gevorderde LLM's vereis 'n mate van maatwerk om uit te blink in spesifieke take of domeine. Dit is waar fynverstelling inkom. Nadat 'n model aanvanklik op 'n groot datastel opgelei is, kan dit verder verfyn word, of 'fynverstel' word op 'n kleiner, meer spesifieke datastel. Hierdie proses laat die model toe om sy algemene taalbegripvermoëns aan te pas by 'n meer gespesialiseerde taak of konteks.

Vinnige Ingenieurswese

Invoeraanwysings dien as die beginpunt vir LLM's om uitsette te genereer. Om hierdie aanwysings effektief te maak, 'n praktyk bekend as vinnige ingenieurswese, kan die kwaliteit van die model se reaksies grootliks beïnvloed. Dit is 'n mengsel van kuns en wetenskap wat 'n skerp begrip vereis van hoe die model aansporings interpreteer en reaksies genereer.

Vooroordeel

Soos LLM's leer uit die data waarop hulle opgelei is, kan enige vooroordeel wat in hierdie data voorkom, die model se gedrag infiltreer. Dit kan manifesteer as diskriminerende of onbillike neigings in die model se uitsette. Die aanspreek en versagting van hierdie vooroordele is 'n belangrike uitdaging op die gebied van KI en 'n deurslaggewende aspek van die ontwikkeling van eties gesonde LLM's.

Interpreteerbaarheid

Gegewe die kompleksiteit van LLM's, kan dit 'n uitdaging wees om te verstaan waarom hulle sekere besluite neem of spesifieke uitsette genereer. Hierdie eienskap, bekend as interpreteerbaarheid, is 'n sleutelarea van deurlopende navorsing. Die verbetering van interpreteerbaarheid help nie net met probleemoplossing en modelverfyning nie, maar dit versterk ook vertroue en deursigtigheid in KI-stelsels.

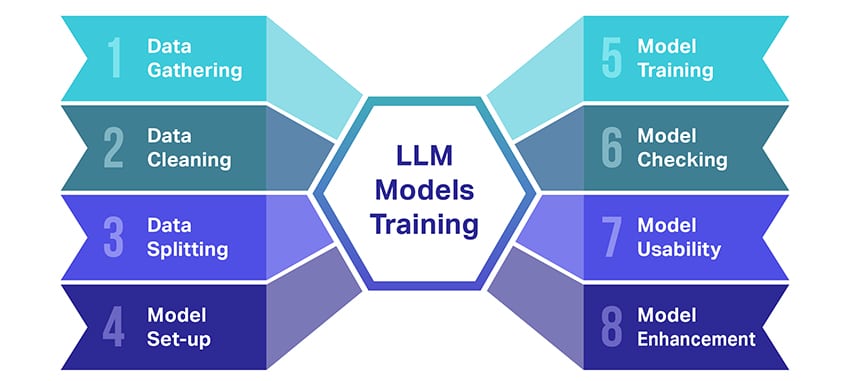

Hoe word LLM-modelle opgelei?

Opleiding van groot taalmodelle (LLM's) is nogal 'n prestasie wat verskeie belangrike stappe behels. Hier is 'n vereenvoudigde, stap-vir-stap oorsig van die proses:

- Versamel teksdata: Opleiding van 'n LLM begin met die versameling van 'n groot hoeveelheid teksdata. Hierdie data kan van boeke, webwerwe, artikels of sosiale media-platforms kom. Die doel is om die ryk diversiteit van menslike taal vas te vang.

- Maak die data skoon: Die rou teksdata word dan opgeruim in 'n proses wat voorafverwerking genoem word. Dit sluit take in soos die verwydering van ongewenste karakters, die opbreek van die teks in kleiner dele wat tokens genoem word, en om dit alles in 'n formaat te kry waarmee die model kan werk.

- Verdeel die data: Vervolgens word die skoon data in twee stelle verdeel. Een stel, die opleidingsdata, sal gebruik word om die model op te lei. Die ander stel, die valideringsdata, sal later gebruik word om die model se werkverrigting te toets.

- Stel die model op: Die struktuur van die LLM, bekend as die argitektuur, word dan gedefinieer. Dit behels die keuse van die tipe neurale netwerk en die besluit oor verskeie parameters, soos die aantal lae en versteekte eenhede binne die netwerk.

- Opleiding van die model: Die werklike opleiding begin nou. Die LLM-model leer deur na die opleidingsdata te kyk, voorspellings te maak gebaseer op wat dit tot dusver geleer het, en dan sy interne parameters aan te pas om die verskil tussen sy voorspellings en die werklike data te verminder.

- Kontroleer die model: Die LLM-model se leer word nagegaan deur die valideringsdata te gebruik. Dit help om te sien hoe goed die model vaar en om die model se instellings aan te pas vir beter werkverrigting.

- Die gebruik van die model: Na opleiding en evaluering is die LLM-model gereed vir gebruik. Dit kan nou geïntegreer word in toepassings of stelsels waar dit teks sal genereer op grond van nuwe insette wat dit gegee word.

- Verbetering van die model: Ten slotte, daar is altyd ruimte vir verbetering. Die LLM-model kan mettertyd verder verfyn word deur opgedateerde data te gebruik of instellings aan te pas gebaseer op terugvoer en werklike gebruik.

Onthou, hierdie proses vereis aansienlike rekenaarhulpbronne, soos kragtige verwerkingseenhede en groot berging, sowel as gespesialiseerde kennis in masjienleer. Daarom word dit gewoonlik gedoen deur toegewyde navorsingsorganisasies of maatskappye met toegang tot die nodige infrastruktuur en kundigheid.

Maak die LLM staat op leer onder toesig of sonder toesig?

Groot taalmodelle word gewoonlik opgelei deur gebruik te maak van 'n metode wat toesigleer genoem word. In eenvoudige terme beteken dit dat hulle uit voorbeelde leer wat vir hulle die korrekte antwoorde wys.

Dus, as jy 'n LLM 'n sin gee, probeer dit die volgende woord of frase voorspel op grond van wat dit uit die voorbeelde geleer het. Op hierdie manier leer dit hoe om teks te genereer wat sin maak en by die konteks pas.

Dit gesê, soms gebruik LLM's ook 'n bietjie leer sonder toesig. Dit is soos om die kind 'n kamer vol verskillende speelgoed te laat verken en op hul eie daaroor te leer. Die model kyk na ongemerkte data, leerpatrone en strukture sonder om die "regte" antwoorde te vertel.

Leer onder toesig gebruik data wat met insette en uitsette gemerk is, in teenstelling met leer sonder toesig, wat nie gemerkte uitsetdata gebruik nie.

In 'n neutedop, LLM's word hoofsaaklik opgelei deur leer onder toesig, maar hulle kan ook leer sonder toesig gebruik om hul vermoëns te verbeter, soos vir verkennende analise en dimensionaliteitvermindering.

Wat is die datavolume (in GB) wat nodig is om 'n groot taalmodel op te lei?

Die wêreld van moontlikhede vir spraakdata-herkenning en stemtoepassings is geweldig, en dit word in verskeie industrieë vir 'n oorvloed toepassings gebruik.

Die opleiding van 'n groot taalmodel is nie 'n een-grootte-pas-almal-proses nie, veral as dit kom by die data wat benodig word. Dit hang af van 'n klomp dinge:

- Die model ontwerp.

- Watter werk moet dit doen?

- Die tipe data wat jy gebruik.

- Hoe goed wil jy hê dit moet presteer?

Dit gesê, opleiding LLM's vereis gewoonlik 'n groot hoeveelheid teksdata. Maar van hoe massief praat ons? Wel, dink verder as gigagrepe (GB). Ons kyk gewoonlik na teragrepe (TB) of selfs petagrepe (PB) data.

Oorweeg GPT-3, een van die grootste LLM's in die wêreld. Dit word opgelei op 570 GB teksdata. Kleiner LLM's het dalk minder nodig – miskien 10-20 GB of selfs 1 GB gigagrepe – maar dit is steeds baie.

Maar dit gaan nie net oor die grootte van die data nie. Kwaliteit maak ook saak. Die data moet skoon en gevarieerd wees om die model effektief te help leer. En jy kan nie vergeet van ander sleutelstukke van die legkaart nie, soos die rekenaarkrag wat jy nodig het, die algoritmes wat jy vir opleiding gebruik en die hardeware-opstelling wat jy het. Al hierdie faktore speel 'n groot rol in die opleiding van 'n LLM.

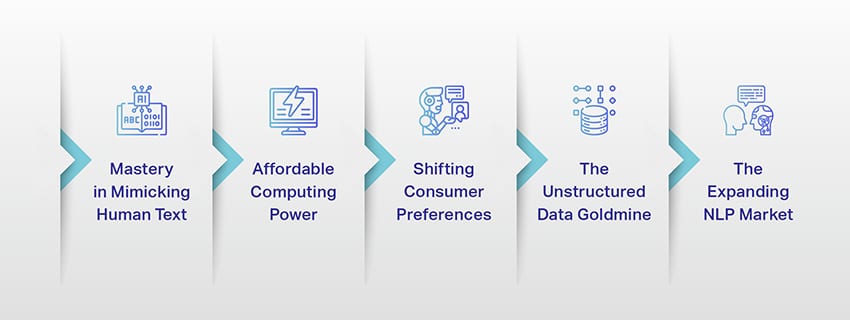

Die opkoms van groot taalmodelle: waarom hulle saak maak

LLM's is nie meer net 'n konsep of 'n eksperiment nie. Hulle speel toenemend 'n kritieke rol in ons digitale landskap. Maar hoekom gebeur dit? Wat maak hierdie LLM's so belangrik? Kom ons delf na 'n paar sleutelfaktore.

Bemeestering in die nabootsing van menslike teks

LLM's het die manier waarop ons taalgebaseerde take hanteer, verander. Gebou met behulp van robuuste masjienleeralgoritmes, is hierdie modelle toegerus met die vermoë om die nuanses van menslike taal, insluitend konteks, emosie en selfs sarkasme, tot 'n mate te verstaan. Hierdie vermoë om menslike taal na te boots is nie 'n blote nuwigheid nie, dit het beduidende implikasies.

LLM's se gevorderde teksgenereringsvermoëns kan alles van inhoudskepping tot kliëntediensinteraksies verbeter.

Stel jou voor dat jy 'n komplekse vraag aan 'n digitale assistent kan vra en 'n antwoord kry wat nie net sin maak nie, maar ook samehangend, relevant is en in 'n gesprekstoon gelewer word. Dit is wat LLM's in staat stel. Dit bevorder 'n meer intuïtiewe en boeiende mens-masjien-interaksie, verryk gebruikerservarings en demokratiseer toegang tot inligting.

Bekostigbare rekenaarkrag

Die opkoms van LLM's sou nie moontlik gewees het sonder parallelle ontwikkelings in die veld van rekenaars nie. Meer spesifiek, die demokratisering van rekenaarhulpbronne het 'n beduidende rol gespeel in die evolusie en aanvaarding van LLM's.

Wolk-gebaseerde platforms bied ongekende toegang tot hoëprestasie-rekenaarhulpbronne. Op hierdie manier kan selfs kleinskaalse organisasies en onafhanklike navorsers gesofistikeerde masjienleermodelle oplei.

Boonop het verbeterings in verwerkingseenhede (soos GPU's en TPU's), gekombineer met die opkoms van verspreide rekenaars, dit haalbaar gemaak om modelle met miljarde parameters op te lei. Hierdie verhoogde toeganklikheid van rekenaarkrag maak die groei en sukses van LLM's moontlik, wat lei tot meer innovasie en toepassings in die veld.

Verandering van verbruikersvoorkeure

Verbruikers vandag wil nie net antwoorde hê nie; hulle wil innemende en verwante interaksies hê. Soos meer mense grootword met behulp van digitale tegnologie, is dit duidelik dat die behoefte aan tegnologie wat meer natuurlik en mensagtig voel, toeneem. LLM's bied 'n ongeëwenaarde geleentheid om aan hierdie verwagtinge te voldoen. Deur mensagtige teks te genereer, kan hierdie modelle innemende en dinamiese digitale ervarings skep, wat gebruikerstevredenheid en lojaliteit kan verhoog. Of dit nou KI-kletsbotte is wat kliëntediens lewer of stemassistente is wat nuusopdaterings verskaf, LLM's lui 'n era van KI in wat ons beter verstaan.

Die ongestruktureerde data goudmyn

Ongestruktureerde data, soos e-posse, sosiale media-plasings en klantresensies, is 'n skatkis van insigte. Daar word beraam dat verby 80% van ondernemingsdata is ongestruktureerd en groei teen 'n tempo van 55% per jaar. Hierdie data is 'n goudmyn vir besighede as dit behoorlik aangewend word.

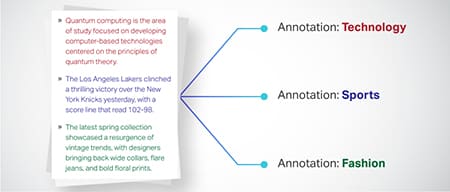

LLM's kom hier ter sprake, met hul vermoë om sulke data op skaal te verwerk en sin te maak. Hulle kan take soos sentimentanalise, teksklassifikasie, inligtingonttrekking en meer hanteer, en sodoende waardevolle insigte verskaf.

Of dit nou is om tendense uit sosiale media-plasings te identifiseer of om klante-sentiment uit resensies te meet, LLM's help besighede om die groot hoeveelheid ongestruktureerde data te navigeer en datagedrewe besluite te neem.

Die groeiende NLP-mark

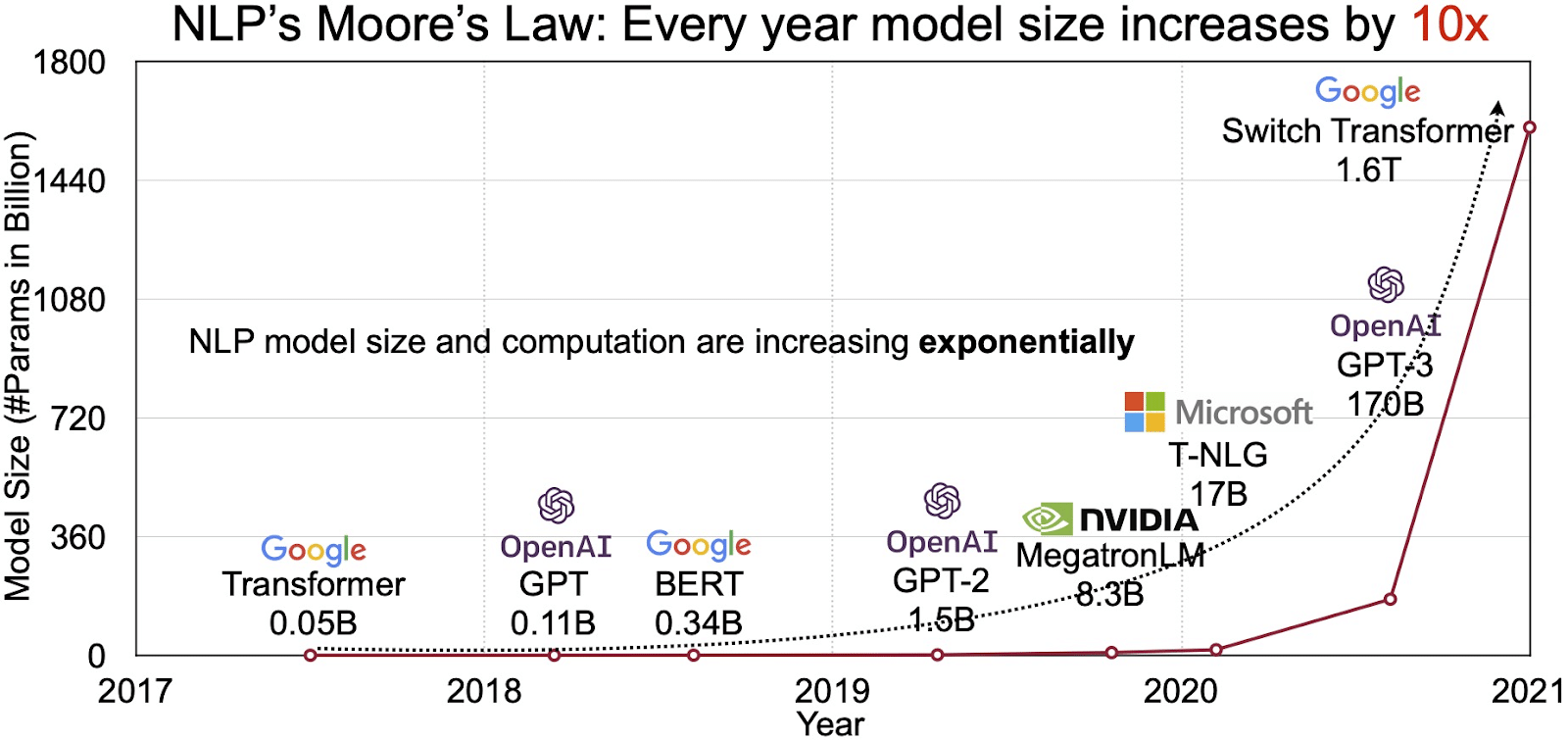

Die potensiaal van LLM's word weerspieël in die vinnig groeiende mark vir natuurlike taalverwerking (NLP). Ontleders projekteer die NLP-mark om van uit te brei $11 miljard in 2020 tot meer as $35 miljard teen 2026. Maar dit is nie net die markgrootte wat uitbrei nie. Die modelle self groei ook, beide in fisiese grootte en in die aantal parameters wat hulle hanteer. Die evolusie van LLM's oor die jare, soos gesien in die onderstaande figuur (beeldbron: skakel), onderstreep hul toenemende kompleksiteit en kapasiteit.

Gewilde gebruiksgevalle van groot taalmodelle

Hier is 'n paar van die top en mees algemene gebruiksgevalle van LLM:

- Genereer natuurlike taal teks: Groot taalmodelle (LLM's) kombineer die krag van kunsmatige intelligensie en rekenaarlinguistiek om outonoom tekste in natuurlike taal te produseer. Hulle kan in uiteenlopende gebruikersbehoeftes voorsien, soos om artikels neer te skryf, liedjies te maak of in gesprekke met gebruikers betrokke te raak.

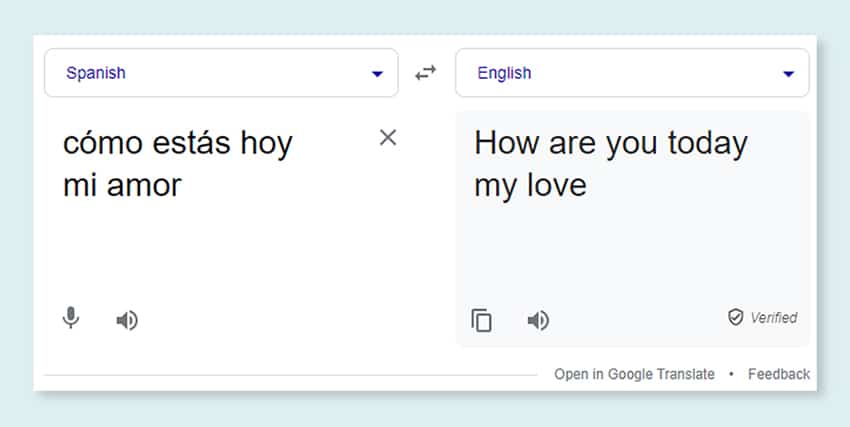

- Vertaling deur masjiene: LLM's kan effektief aangewend word om teks tussen enige paar tale te vertaal. Hierdie modelle ontgin diepleeralgoritmes soos herhalende neurale netwerke om die linguistiese struktuur van beide bron- en teikentale te begryp en sodoende die vertaling van die bronteks in die verlangde taal te vergemaklik.

- Skep oorspronklike inhoud: LLM's het weë oopgemaak vir masjiene om samehangende en logiese inhoud te genereer. Hierdie inhoud kan gebruik word om blogplasings, artikels en ander soorte inhoud te skep. Die modelle benut hul diepgaande diep-leerervaring om die inhoud op 'n nuwe en gebruikersvriendelike manier te formateer en te struktureer.

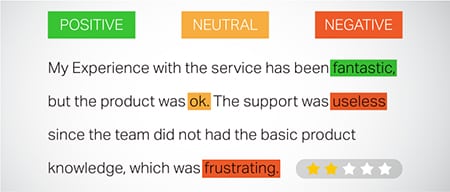

- Ontleed sentimente: Een interessante toepassing van groottaalmodelle is sentimentanalise. Hierin word die model opgelei om emosionele toestande en sentimente wat in die geannoteerde teks voorkom, te herken en te kategoriseer. Die sagteware kan emosies soos positiwiteit, negatiwiteit, neutraliteit en ander ingewikkelde sentimente identifiseer. Dit kan waardevolle insigte verskaf oor klantterugvoer en sienings oor verskeie produkte en dienste.

- Verstaan, opsom en klassifiseer teks: LLM's vestig 'n lewensvatbare struktuur vir KI-sagteware om die teks en sy konteks te interpreteer. Deur die model opdrag te gee om groot hoeveelhede data te verstaan en te ondersoek, stel LLM's KI-modelle in staat om teks in uiteenlopende vorme en patrone te verstaan, op te som en selfs te kategoriseer.

- Vrae beantwoord: Groot taalmodelle rus Vraagbeantwoording (QA) stelsels toe met die vermoë om 'n gebruiker se natuurlike taalnavraag akkuraat waar te neem en daarop te reageer. Gewilde voorbeelde van hierdie gebruiksgeval sluit ChatGPT en BERT in, wat die konteks van 'n navraag ondersoek en deur 'n groot versameling tekste sif om relevante antwoorde op gebruikersvrae te lewer.

Integrasie van sekuriteit en nakoming in LLM-datastrategieë

Deur robuuste sekuriteits- en voldoeningsmaatreëls binne LLM-data-insameling- en verwerkingsraamwerke in te sluit, kan jou help om data se deursigtige, veilige en etiese gebruik te verseker. Hierdie benadering sluit verskeie sleutelaksies in:

- Implementeer robuuste enkripsie: Beveilig data in rus en tydens vervoer deur sterk enkripsiemetodes te gebruik. Hierdie stap beskerm inligting teen ongemagtigde toegang en oortredings.

- Vestig toegangskontroles en verifikasie: Stel stelsels op om gebruikersidentiteite te verifieer en toegang tot data te beperk. Dit sal verseker dat slegs gemagtigde personeel met sensitiewe inligting kan kommunikeer.

- Integreer log- en moniteringstelsels: Ontplooi stelsels om datagebruik na te spoor en potensiële sekuriteitsbedreigings te identifiseer. Hierdie proaktiewe monitering help om die integriteit en veiligheid van die data-ekosisteem te handhaaf.

- Voldoen aan voldoeningstandaarde: Volg relevante regulasies soos GDPR, HIPAA en PCI DSS, wat datasekuriteit en privaatheid beheer. Gereelde oudits en kontroles verifieer voldoening, om te verseker dat praktyke voldoen aan industrie-spesifieke wetlike en etiese standaarde.

- Stel riglyne vir die gebruik van etiese data: Ontwikkel en handhaaf beleide wat die regverdige, deursigtige en verantwoordbare gebruik van data dikteer. Hierdie riglyne help om belangegroepvertroue te handhaaf en 'n veilige opleidingsomgewing vir LLM's te ondersteun.

Hierdie aksies versterk gesamentlik die databestuurspraktyke vir LLM-opleiding. Dit bou 'n grondslag van vertroue en sekuriteit wat alle betrokkenes bevoordeel.

Verfyning van 'n groot taalmodel

Om 'n groot taalmodel fyn in te stel behels 'n noukeurige annotasieproses. Shaip, met sy kundigheid op hierdie gebied, kan hierdie poging aansienlik aanhelp. Hier is 'n paar aantekeningmetodes wat gebruik word om modelle soos ChatGPT op te lei:

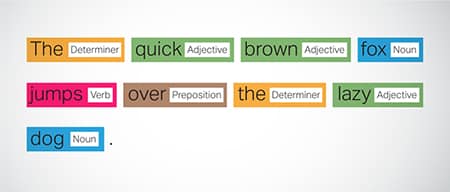

Gedeeltelike (POS)-etikettering

Woorde in sinne word gemerk met hul grammatikale funksie, soos werkwoorde, selfstandige naamwoorde, byvoeglike naamwoorde, ens. Hierdie proses help die model om die grammatika en die skakels tussen woorde te verstaan.

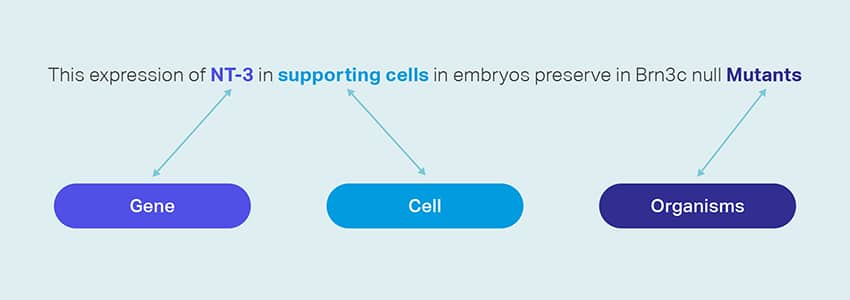

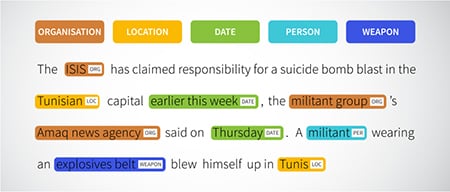

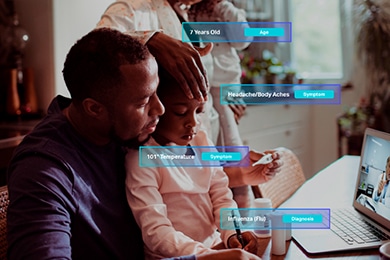

Benoemde entiteitsherkenning (NER)

Benoemde entiteite soos organisasies, liggings en mense binne 'n sin word gemerk. Hierdie oefening help die model om die semantiese betekenisse van woorde en frases te interpreteer en verskaf meer presiese response.

Sentimentanalise

Teksdata kry sentimentetikette soos positief, neutraal of negatief, wat die model help om die emosionele ondertoon van sinne te begryp. Dit is veral nuttig om te reageer op navrae wat emosies en opinies behels.

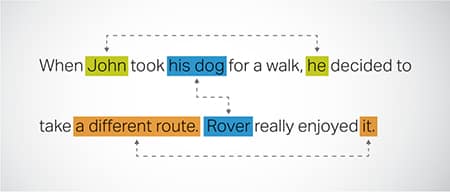

Coreference Resolusie

Identifisering en oplossing van gevalle waar na dieselfde entiteit in verskillende dele van 'n teks verwys word. Hierdie stap help die model om die konteks van die sin te verstaan, en lei dus tot samehangende response.

Teks Klassifikasie

Teksdata word gekategoriseer in voorafbepaalde groepe soos produkresensies of nuusartikels. Dit help die model om die genre of onderwerp van die teks te onderskei, en genereer meer pertinente response.

Shaip kan opleidingsdata insamel deur webkruipery uit verskeie sektore soos bankwese, versekering, kleinhandel en telekommunikasie. Ons kan teksaantekeninge verskaf (NER, sentimentanalise, ens.), meertalige LLM (vertaling) fasiliteer en help met die skepping van taksonomie, onttrekking/spoedige ingenieurswese.

Shaip het 'n uitgebreide bewaarplek van datastelle wat op die rak beskikbaar is. Ons mediese datakatalogus spog met 'n wye versameling gede-geïdentifiseerde, veilige en kwaliteit data wat geskik is vir KI-inisiatiewe, masjienleermodelle en natuurlike taalverwerking.

Net so is ons spraakdatakatalogus 'n skatkis van hoëgehalte data wat perfek is vir stemherkenningsprodukte, wat doeltreffende opleiding van KI/ML-modelle moontlik maak. Ons het ook 'n indrukwekkende rekenaarvisie-datakatalogus met 'n wye reeks beeld- en videodata vir verskeie toepassings.

Ons bied selfs oop datastelle in 'n veranderbare en gerieflike vorm, gratis, vir gebruik in jou KI- en ML-projekte. Hierdie groot KI-databiblioteek bemagtig jou om jou KI- en ML-modelle meer doeltreffend en akkuraat te ontwikkel.

Shaip se data-insameling en annotasieproses

Wanneer dit kom by data-insameling en annotasie, Shaip volg 'n vaartbelynde werkvloei. Hier is hoe die data-insamelingsproses lyk:

Identifikasie van Bronwebwerwe

Aanvanklik word webwerwe vasgestel deur geselekteerde bronne en sleutelwoorde te gebruik wat relevant is tot die data wat benodig word.

Webskraap

Sodra die relevante webwerwe geïdentifiseer is, gebruik Shaip sy eie instrument om data van hierdie webwerwe af te skraap.

Teksvoorverwerking

Die versamelde data ondergaan aanvanklike verwerking, wat sinsplitsing en ontleding insluit, wat dit geskik maak vir verdere stappe.

Body

Die voorafverwerkte data is geannoteer vir Benoemde Entiteit-onttrekking. Hierdie proses behels die identifisering en etikettering van belangrike elemente binne die teks, soos name van mense, organisasies, liggings, ens.

Verhouding onttrekking

In die laaste stap word die tipes verhoudings tussen die geïdentifiseerde entiteite bepaal en dienooreenkomstig geannoteer. Dit help om die semantiese verbande tussen verskillende komponente van die teks te verstaan.

Shaip se offer

Shaip bied 'n wye reeks dienste om organisasies te help om hul data te bestuur, te ontleed en die meeste van hul data te maak.

Data-webskraping

Een sleuteldiens wat deur Shaip aangebied word, is dataskraping. Dit behels die onttrekking van data vanaf domeinspesifieke URL's. Deur geoutomatiseerde gereedskap en tegnieke te gebruik, kan Shaip vinnig en doeltreffend groot volumes data van verskeie webwerwe, produkhandleidings, tegniese dokumentasie, aanlynforums, aanlynresensies, kliëntediensdata, bedryfsregulerende dokumente, ens. Hierdie proses kan van onskatbare waarde wees vir besighede wanneer die insameling van relevante en spesifieke data uit 'n menigte bronne.

Masjienvertaling

Ontwikkel modelle met behulp van uitgebreide veeltalige datastelle gepaard met ooreenstemmende transkripsies vir die vertaling van teks oor verskeie tale. Hierdie proses help om linguistiese struikelblokke uit die weg te ruim en bevorder die toeganklikheid van inligting.

Taksonomie-ontginning en -skepping

Shaip kan help met taksonomie-onttrekking en skepping. Dit behels die klassifikasie en kategorisering van data in 'n gestruktureerde formaat wat die verwantskappe tussen verskillende datapunte weerspieël. Dit kan veral nuttig wees vir besighede om hul data te organiseer, wat dit meer toeganklik en makliker maak om te ontleed. Byvoorbeeld, in 'n e-handelsonderneming kan produkdata gekategoriseer word op grond van produktipe, handelsmerk, prys, ens., wat dit makliker maak vir kliënte om die produkkatalogus te navigeer.

Data-insameling

Ons data-insamelingsdienste verskaf kritiese werklike of sintetiese data wat nodig is vir die opleiding van generatiewe KI-algoritmes en die verbetering van die akkuraatheid en doeltreffendheid van u modelle. Die data is onbevooroordeeld, eties en verantwoordelik verkry, terwyl data privaatheid en sekuriteit in gedagte gehou word.

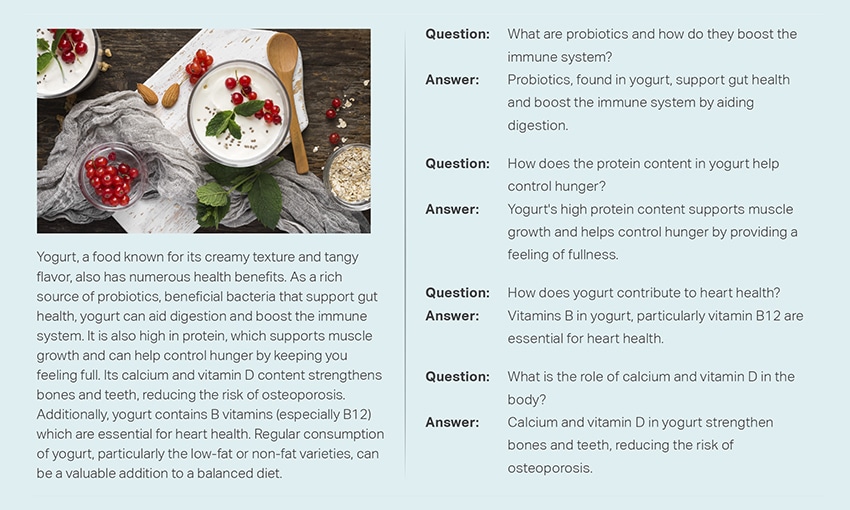

Vraag & Antwoord

Vraagantwoord (QA) is 'n subveld van natuurlike taalverwerking wat daarop gefokus is om vrae outomaties in menslike taal te beantwoord. QA-stelsels word opgelei in uitgebreide teks en kode, wat hulle in staat stel om verskeie tipes vrae te hanteer, insluitend feitelike, definisie- en opinie-gebaseerde vrae. Domeinkennis is noodsaaklik vir die ontwikkeling van QA-modelle wat aangepas is vir spesifieke velde soos kliëntediens, gesondheidsorg of voorsieningsketting. Generatiewe QA-benaderings laat modelle egter toe om teks sonder domeinkennis te genereer, wat uitsluitlik op konteks staatmaak.

Ons span spesialiste kan omvattende dokumente of handleidings noukeurig bestudeer om Vraag-Antwoord-pare te genereer, wat die skepping van Generatiewe KI vir besighede vergemaklik. Hierdie benadering kan gebruikersnavrae effektief aanpak deur relevante inligting uit 'n uitgebreide korpus te ontgin. Ons gesertifiseerde kundiges verseker die produksie van topgehalte V&A-pare wat oor uiteenlopende onderwerpe en domeine strek.

Teks Opsomming

Ons spesialiste is in staat om omvattende gesprekke of lang dialoë te distilleer, en lewer bondige en insiggewende opsommings uit uitgebreide teksdata.

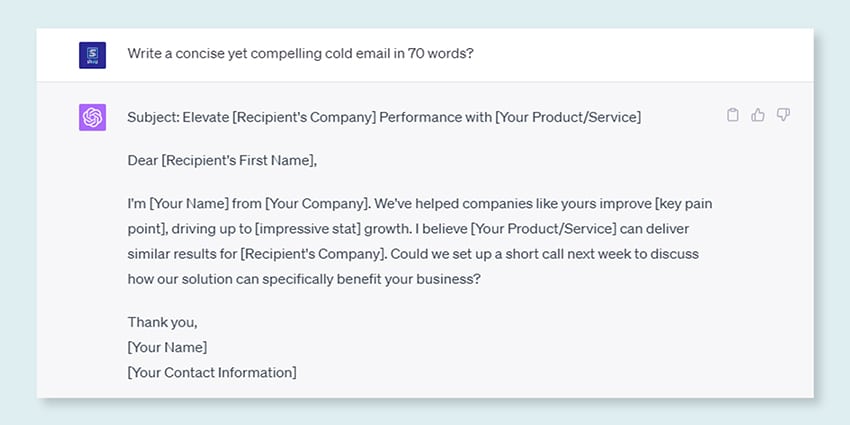

Teks Generasie

Lei modelle op deur 'n breë datastel van teks in uiteenlopende style te gebruik, soos nuusartikels, fiksie en poësie. Hierdie modelle kan dan verskeie tipes inhoud genereer, insluitend nuusstukke, bloginskrywings of sosiale media-plasings, wat 'n koste-effektiewe en tydbesparende oplossing vir inhoudskepping bied.

Spraakherkenning

Ontwikkel modelle wat in staat is om gesproke taal vir verskeie toepassings te verstaan. Dit sluit stemgeaktiveerde assistente, dikteersagteware en intydse vertaalhulpmiddels in. Die proses behels die gebruik van 'n omvattende datastel wat bestaan uit oudio-opnames van gesproke taal, saam met hul ooreenstemmende transkripsies.

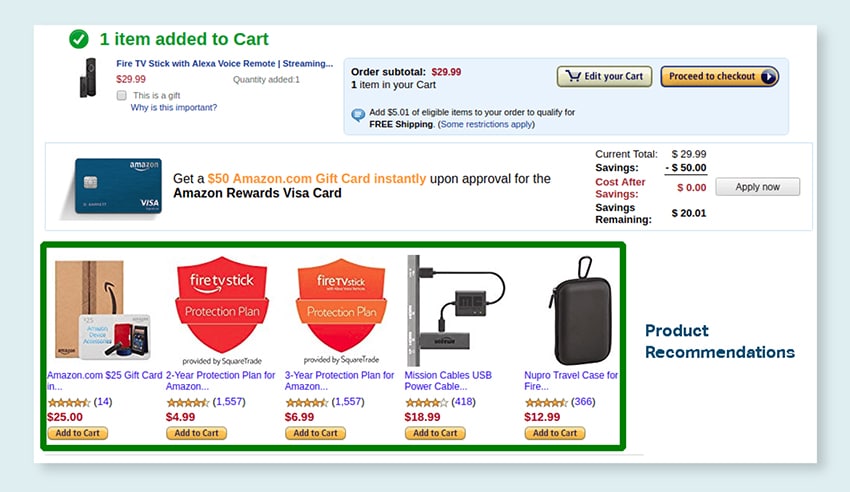

Produkaanbevelings

Ontwikkel modelle met behulp van uitgebreide datastelle van klante se koopgeskiedenis, insluitend etikette wat aandui watter produkte klante geneig is om te koop. Die doel is om presiese voorstelle aan kliënte te verskaf, en sodoende verkope te bevorder en kliëntetevredenheid te verbeter.

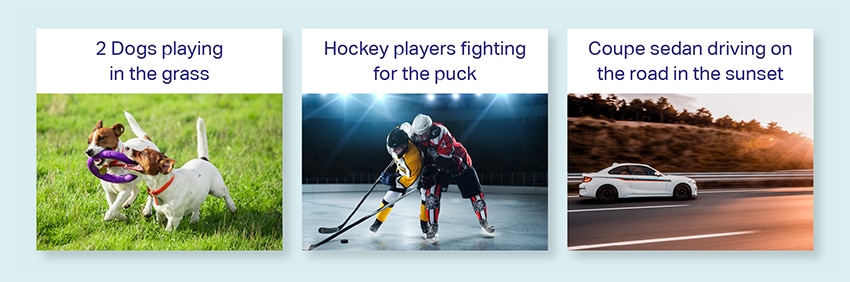

Byskrifte van foto's

Revolusioneer jou beeld interpretasie proses met ons state-of-the-art, KI-gedrewe Image Captioning diens. Ons gee lewenskrag in prente deur akkurate en kontekstueel betekenisvolle beskrywings te produseer. Dit baan die weg vir innoverende betrokkenheid en interaksie moontlikhede met jou visuele inhoud vir jou gehoor.

Opleiding van teks-na-spraak-dienste

Ons verskaf 'n uitgebreide datastel wat bestaan uit menslike spraak-oudio-opnames, ideaal vir die opleiding van KI-modelle. Hierdie modelle is in staat om natuurlike en boeiende stemme vir jou toepassings te genereer en sodoende 'n kenmerkende en meeslepende klankervaring vir jou gebruikers te lewer.

Ons uiteenlopende datakatalogus is ontwerp om voorsiening te maak vir talle Generatiewe KI-gebruiksgevalle

Mediese gegewenskatalogus en lisensiëring buite die rak:

- 5M + neem klanklêers op en dokters in 31 spesialiteite

- 2M + mediese beelde in radiologie en ander spesialiteite (MRI's, CT's, USG's, XR's)

- 30 k + kliniese teksdokumente met toegevoegde waarde-entiteite en verhoudingsaantekening

Spraakdata-katalogus en lisensiëring buite die rak:

- 40k+ uur se spraakdata (50+ tale/100+ dialekte)

- 55+ onderwerpe gedek

- Monstersnelheid - 8/16/44/48 kHz

- Oudiotipe - Spontane, geskrewe, monoloog, wakker woorde

- Volledig getranskribeerde oudiodatastelle in veelvuldige tale vir mens-mens-gesprekke, mens-bot, mens-agent oproepsentrum gesprek, monoloë, toesprake, podcasts, ens.

Beeld- en videodatakatalogus en lisensiëring:

- Kos/dokument-beeldversameling

- Tuis sekuriteit video versameling

- Gesigsbeeld/videoversameling

- Fakture, PO, Kwitansiedokumentversameling vir OCR

- Beeldversameling vir die opsporing van voertuigskade

- Voertuignommerplaatbeeldversameling

- Motor-interieur-beeldversameling

- Beeldversameling met motorbestuurder in fokus

- Modeverwante beeldversameling

Kom ons praat

Algemene vrae (FAQ)

DL is 'n subveld van ML wat kunsmatige neurale netwerke met veelvuldige lae gebruik om komplekse patrone in data te leer. ML is 'n subset van KI wat fokus op algoritmes en modelle wat masjiene in staat stel om uit data te leer. Groot taalmodelle (LLM's) is 'n subset van diep leer en deel gemeenskaplike grond met generatiewe KI, aangesien albei komponente van die breër veld van diep leer is.

Groot taalmodelle, of LLM's, is uitgebreide en veelsydige taalmodelle wat aanvanklik vooraf op uitgebreide teksdata opgelei is om die fundamentele aspekte van taal te begryp. Hulle word dan verfyn vir spesifieke toepassings of take, sodat hulle aangepas en geoptimaliseer kan word vir spesifieke doeleindes.

Eerstens beskik groot taalmodelle oor die vermoë om 'n wye reeks take te hanteer as gevolg van hul uitgebreide opleiding met massiewe hoeveelhede data en biljoene parameters.

Tweedens toon hierdie modelle aanpasbaarheid aangesien hulle met minimale spesifieke veldopleidingsdata verfyn kan word.

Laastens toon die prestasie van LLM's voortdurende verbetering wanneer bykomende data en parameters ingesluit word, wat hul doeltreffendheid mettertyd verbeter.

Vinnige ontwerp behels die skep van 'n aansporing wat aangepas is vir die spesifieke taak, soos om die verlangde uitvoertaal in 'n vertaaltaak te spesifiseer. Vinnige ingenieurswese, aan die ander kant, fokus op die optimalisering van werkverrigting deur domeinkennis in te sluit, uitsetvoorbeelde te verskaf of effektiewe sleutelwoorde te gebruik. Vinnige ontwerp is 'n algemene konsep, terwyl vinnige ingenieurswese 'n gespesialiseerde benadering is. Terwyl vinnige ontwerp noodsaaklik is vir alle stelsels, word vinnige ingenieurswese noodsaaklik vir stelsels wat hoë akkuraatheid of werkverrigting vereis.

Daar is drie tipes groot taalmodelle. Elke tipe vereis 'n ander benadering tot bevordering.

- Generiese taalmodelle voorspel die volgende woord gebaseer op die taal in die opleidingsdata.

- Instruksie-gestemde modelle word opgelei om reaksie op die instruksies wat in die insette gegee word, te voorspel.

- Dialoog-gestemde modelle word opgelei om 'n dialoogagtige gesprek te voer deur die volgende reaksie te genereer.